Στο επόμενο ετήσιο συνέδριο για την Τεχνητή Νοημοσύνη της αμερικάνικης εταιρείας Nvidia, που απευθύνεται σε πάνω από 3,5 εκατομμύρια προγραμματιστές που εργάζονται στην πλατφόρμα της, ο ιδρυτής και διευθύνων σύμβουλος Jensen Huang θα καλέσει τον Ilya Sutskever, συνιδρυτή και επικεφαλής επιστήμονα του OpenAI, σε συζήτηση. Η συζήτηση θα στείλει σίγουρα ένα συμβολικό μήνυμα ότι η Nvidia δεν έχει καμία πρόθεση να παραχωρήσει την κυριαρχία της στην Tεχνητή Nοημοσύνη (ΤΝ), που ξεκίνησε όταν η εταιρεία βοήθησε στην "επανάσταση" της λεγόμενης «βαθιάς μάθησης» (deep learning) πριν από μια δεκαετία. Και η Nvidia δεν δείχνει σημάδια απώλειας του προβάδισματός της καθώς η παραγωγική τεχνητή νοημοσύνη (Generative AI) εκρήγνυται με εργαλεία όπως το ChatGPT.

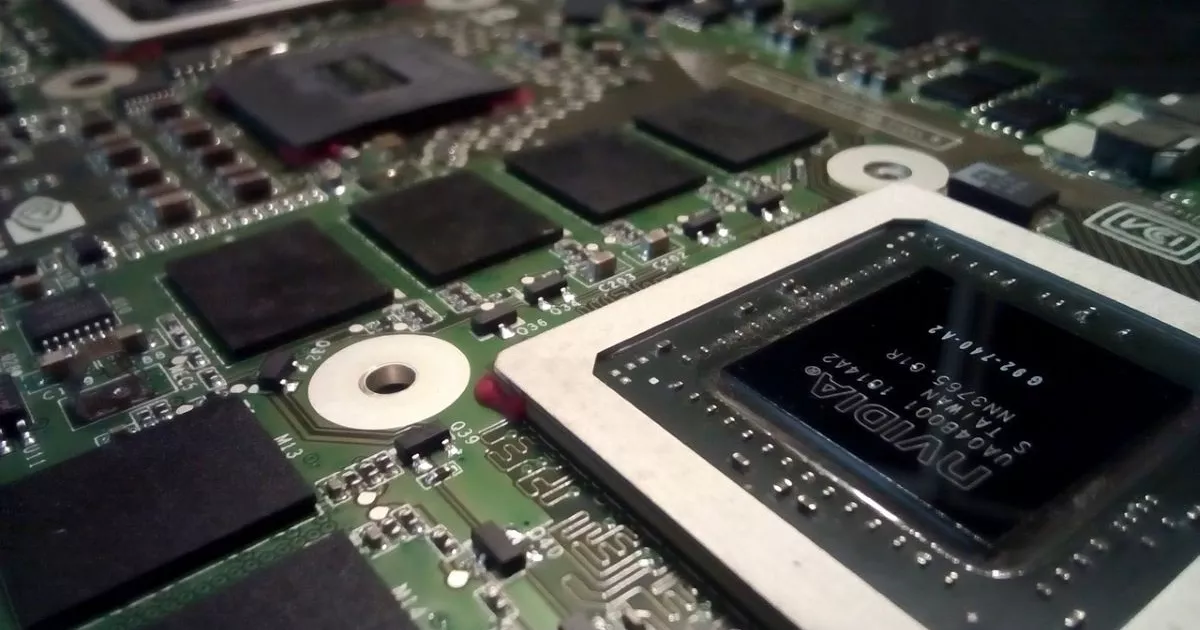

Άλλωστε η Nvidia παρέχει την τεχνολογία στους πρωτοπόρους σε αυτόν τον τομέα της ΤΝ. Το 2012, ο Sutskever, μαζί με τον Alex Krizhevsky και τον Geoffrey Hinton, δημιούργησαν το AlexNet, το πρωτοποριακό νευρωνικό δίκτυο για την όραση υπολογιστών που κέρδισε τον διαγωνισμό ImageNet εκείνης της χρονιάς. Η βραβευμένη εργασία τους, η οποία έδειξε ότι το μοντέλο πέτυχε ακρίβεια αναγνώρισης εικόνων που δεν είχε ξαναγίνει ποτέ, οδήγησε άμεσα στις μεγάλες επιτυχίες της τεχνητής νοημοσύνης της επόμενης δεκαετίας, από το Google Photos, το Google Translate και την Uber μέχρι την Alexa και την AlphaFold. Σύμφωνα με τον Hinton, όμως, το AlexNet δεν θα είχε συμβεί χωρίς τη Nvidia. Χάρη στις δυνατότητες παράλληλης επεξεργασίας που υποστηρίζονται από χιλιάδες υπολογιστικούς πυρήνες, οι GPU της Nvidia, οι οποίες δημιουργήθηκαν το 1999 για τα υπερταχύτατα τρισδιάστατα γραφικά σε βιντεοπαιχνίδια ηλεκτρονικών υπολογιστών, είχαν αρχίσει να βελτιστοποιούνται για γενικές υπολογιστικές λειτουργίες και αποδείχθηκαν ιδανικές για την εκτέλεση αλγορίθμων βαθιάς μάθησης.

Ωστόσο, ο Sutskever αντιπροσωπεύει επίσης την έκρηξη του hype για την Τεχνητή Νοημοσύνη το 2023, καθώς μεγάλα γλωσσικά μοντέλα όπως το ChatGPT και το DALL-E 2 έχουν εισβάλει στη συνείδηση του κοινού με τρόπο που δεν έχει παρατηρηθεί, ίσως, από την αυγή του iPhone το 2007. Και αυτό, επίσης, δεν θα ήταν εφικτό χωρίς τη Nvidia. Τα σημερινά μαζικά παραγωγικά μοντέλα τεχνητής νοημοσύνης απαιτούν χιλιάδες GPU για να τρέξουν και η Nvidia κατέχει περίπου το 88% της αγοράς GPU, σύμφωνα με την John Peddie Research. Η ίδια η OpenAI φέρεται να χρησιμοποίησε 10.000 GPUs της Nvidia για την εκπαίδευση του ChatGPT.

Πολλοί βλέπουν την Nvidia ως τον μεγαλύτερο νικητή στον χώρο της παραγωγικής τεχνητής νοημοσύνης. Ήδη, η φρενίτιδα έστειλε την τιμή της μετοχής της στα ύψη τον Ιανουάριο. Η Citi, για παράδειγμα, εκτίμησε ότι η χρήση του ChatGPT θα μπορούσε να οδηγήσει σε πωλήσεις ύψους 3 έως 11 δισεκατομμυρίων δολαρίων για την Nvidia σε διάστημα 12 μηνών. Μιλώντας σε αναλυτές, για τα ιδιαίτερα αυξημένα έσοδα του 2023, ο Huang της Nvidia συμφώνησε. Η τεχνητή νοημοσύνη βρίσκεται σε ένα "σημείο καμπής", τους είπε, το οποίο οδηγεί περισσότερες επιχειρήσεις να αγοράζουν περισσότερα τσιπ της Nvidia για την ανάπτυξη λογισμικού ML. "Η ευελιξία και η ικανότητα της τεχνητής νοημοσύνης έχει προκαλέσει μια αίσθηση επείγοντος στις επιχειρήσεις σε όλο τον κόσμο για την ανάπτυξη και την εφαρμογή στρατηγικών τεχνητής νοημοσύνης", σύμφωνα με τον ηγέτη της Nvidia.

Πόσο μπορεί να διαρκέσει η κυριαρχία της Nvidia στην ΤΝ;

Αυτές τις μέρες, λοιπόν, η Nvidia είναι συνώνυμη με την τεχνητή νοημοσύνη. Το ερώτημα είναι, πόσο καιρό μπορεί να διατηρήσει την κυριαρχία της στην τεχνητή νοημοσύνη; Προφανώς, η Nvidia δεν θα έχει για πάντα το πανω χέρι. Οι ανταγωνιστές της, όπως η AMD και η Google, την ακολουθούν, ενώ οι γεωπολιτικές δυνάμεις αιωρούνται απειλητικά (με τον τελευταίο έλεγχο εξαγωγών τσιπ των Ηνωμένων Πολιτειών, οι GPU τελευταίας τεχνολογίας, όπως οι A100 και H100 της Nvidia, δεν μπορούν πλέον να πωλούνται στην Κίνα, για παράδειγμα).

Αλλά η φημισμένη στρατηγική της Nvidia για τις πλατφόρμες και η προσέγγιση που επικεντρώνεται στο λογισμικό εξακολουθεί να είναι πολύ, πολύ δύσκολο να νικηθεί, λένε οι ειδικοί. Ενώ άλλοι παίκτες προσφέρουν τσιπ ή και συστήματα, η Nvidia έχει δημιουργήσει ένα ισχυρό οικοσύστημα που περιλαμβάνει τα τσιπ, το σχετικό υλικό και μια πλήρη σταθερότητα λογισμικού και συστημάτων ανάπτυξης που είναι βελτιστοποιημένα για τα τσιπ και τα συστήματά της.

Η Nvidia ήταν επίσης "πολύ ευέλικτη" με την ενσωμάτωση νέων δυνατοτήτων στο σύστημά της. Άλλες νεοσύστατες εταιρείες τσιπ τεχνητής νοημοσύνης δεν έχουν επενδύσει επαρκώς στην ανάπτυξη εργαλείων λογισμικού, οπότε, ενώ έχουν δημιουργήσει πλατφόρμες υπολογιστικού νέφους που μπορεί να είναι ταχύτερες ή φθηνότερες από αυτές της Nvidia, δεν συνοδεύονται από ανάλογη βελτίωση στην εμπειρία προγραμματισμού.

Ο συνδυασμός GPU + CUDA που άλλαξε το παιχνίδι

Ο Jensen Huang ήξερε πάντα ότι τα τσιπ γραφικών του είχαν περισσότερες δυνατότητες από το να τροφοδοτούν τα πιο πρόσφατα βιντεοπαιχνίδια, αλλά μάλλον δεν περίμενε τη στροφή προς το deep learning. Στην πραγματικότητα, η επιτυχία των GPUs της Nvidia για τα νευρωνικά δίκτυα ήταν "μια παράξενη, τυχερή σύμπτωση", σαν να "κέρδισε το λαχείο". Μεγάλο μέρος της επιτυχίας οφειλόταν στην ευθυγράμμιση μεταξύ της προόδου στην πλευρά του υλικού και της προόδου στην πλευρά της μοντελοποίησης. Μέσα σε μια νύχτα, αυτό που χρειαζόταν 13.000 CPUs, χρειάστηκε δύο GPUs για να γίνει. Τόσο δραματική ήταν η βελτιστοποίηση που έφεραν αυτές οι GPU στο computing.

Φυσικά, η Nvidia υποστηρίζει ότι ήξερε τις δυνατότητες των GPU της για την επιτάχυνση των νευρωνικών δικτύων από τα μέσα της δεκαετίας του 2000, ακόμη και αν δεν γνώριζε ότι η τεχνητή νοημοσύνη θα αποτελούσε τη σημαντικότερη αγορά. Γι' αυτό επενδύσε σημαντικά στην ανάπτυξη της CUDA [αρχιτεκτονική ενοποιημένης υπολογιστικής συσκευής] από την αρχή μέχρι το τέλος, θέτοντας την επιτάχυνση γενικού σκοπού στα χέρια εκατομμυρίων προγραμματιστών. Η προσθήκη του CUDA σε κάθε GPU που κατασκευάζει η Nvidia ήταν ένα τεράστιο στοίχημα.

Η υπολογιστική πλατφόρμα CUDA, την οποία η Nvidia πρόσθεσε το 2007, είναι η στοίβα λογισμικού που επιτρέπει στους ερευνητές να προγραμματίζουν και να έχουν πρόσβαση στην υπολογιστική ισχύ και τον ακραίο παραλληλισμό που επιτρέπουν οι GPU της Nvidia. Και η επανάσταση του deep learning δεν θα είχε συμβεί, τονίζουν ειδικοί τόσο εντός όσο και εκτός της Nvidia, αν η Nvidia δεν είχε προσθέσει το CUDA στο μείγμα το 2007.

Πριν η Nvidia κυκλοφορήσει το CUDA, ο προγραμματισμός μιας GPU ήταν μια μακρά και επίπονη διαδικασία κωδικοποίησης που απαιτούσε τη συγγραφή μεγάλου όγκου κώδικα μηχανής χαμηλού επιπέδου. Χρησιμοποιώντας το CUDA - το οποίο ήταν δωρεάν - οι ερευνητές μπορούσαν να αναπτύξουν τα μοντέλα βαθιάς μάθησης πολύ πιο γρήγορα και φτηνά. Στο υλικό της Nvidia, φυσικά.

Το CUDA έκανε την ισχύ των GPU πιο προσιτή. Και επειδή η Nvidia επέμεινε στο να είναι κάθε νέα γενιά επεξεργαστών συμβατή με το CUDA, στην πράξη έφερε ένα νέο μοντέλο προγραμματισμού.

Το μεγάλο στοίχημα της ΤΝ

Όμως, έξι χρόνια μετά την κυκλοφορία του CUDA, η Nvidia δεν είχε ακόμη "μπει" πλήρως στην τεχνητή νοημοσύνη. Όταν δημοσιεύθηκε το AlexNet και άλλοι ερευνητές ασχολούνταν με τις GPU, δεν υπήρχε κανείς στην Nvidia που να ασχολείται με την τεχνητή νοημοσύνη". Εκτός από τον Bryan Catanzaro.

Εκείνη την εποχή, ο Catanzaro συνεργαζόταν με τον Andrew Ng στο Stanford σε ένα μικρό έργο όπου αντικατέστησαν 1.000 διακομιστές στην Google με τρεις διακομιστές χρησιμοποιώντας GPU και ένα σωρό πυρήνες CUDA που έγραψε η ομάδα τους. Συνομιλούσε επίσης εκείνη την περίοδο με τον Yann LeCun του NYU AI Lab (τώρα επικεφαλής της έρευνας για την τεχνητή νοημοσύνη στη Meta) και τον Rob Fergus (τώρα ερευνητής στη DeepMind). Ο Fergus του είπ ότι πολλοί ερευνητές μηχανικής μάθησης γράφοντας κώδικα για την GPU και ο Cantanzaro το εξέτασε. Πράγματι, οι πελάτες άρχισαν να αγοράζουν μεγάλο αριθμό GPU για βαθιά μάθηση. Τελικά, ο Huang και άλλοι στην Nvidia το έλαβαν υπόψη τους και σήμερα όλοι αγοράζουν Nvidia GPU.

Η στρατηγική της Nvidia έχει επίκεντρο το λογισμικό

Η ιστορία του ImageNet το 2012 περιλάμβανε μερικούς ερευνητές και μια GPU. Αλλά αυτό ήταν μόνο το πρώτο ορόσημο. Η επόμενη πρόκληση ήταν το πώς θα μπορούσε να κλιμακωθεί η ισχύς των GPU, πως θα μπορούσαν να επικοινωνούν μεταξύ τους, έτσι ώστε να περάσουμε από μια GPU σε multi-GPU.

Τα τελευταία επτά χρόνια, η Nvidia έχει επικεντρωθεί στη δημιουργία λογισμικού βαθιάς μάθησης σε βιβλιοθήκες και πλαίσια που αφαιρούν την ανάγκη να χρειάζεται να κωδικοποιήσετε σε CUDA. Τοποθετεί βιβλιοθήκες με επιτάχυνση CUDA, όπως η cuDNN, σε πιο ευρέως χρησιμοποιούμενες βιβλιοθήκες βασισμένες στην Python, όπως η PyTorch και η TensorFlow. Τώρα, εκατοντάδες και χιλιάδες GPUs μπορούν να «μιλούν» μεταξύ τους για να εκπαιδευτεί ένα νευρωνικό δίκτυο. Αρχικά, για να εκπαιδευτεί το ίδιο νευρωνικό δίκτυο χρειάζονται μήνες, και μετά εβδομάδες. Σήμερα η ίδια διαδικασία χρειάζεται δευτερόλεπτα.

Επιπλέον, μέχρι το 2018 οι GPUs χρησιμοποιήθηκαν όχι μόνο για εκπαίδευση ΤΝ, αλλά και για εξαγωγή συμπερασμάτων, για την υποστήριξη δυνατοτήτων στην αναγνώριση ομιλίας, την επεξεργασία φυσικής γλώσσας, και την αναγνώριση εικόνας. Αυτό σήμαινε όχι μόνο περισσότερο υλικό, όπως το τσιπ T4 της Nvidia, αλλά και περισσότερο λογισμικό για να τροφοδοτήσει αυτούς τους φόρτους εργασίας εξαγωγής συμπερασμάτων σε πραγματικό χρόνο στο κέντρο δεδομένων και σε εφαρμογές αυτοκινήτων, καθώς και σε ρομπότ και μη επανδρωμένα αεροσκάφη.

Ως αποτέλεσμα, η Nvidia έχει γίνει περισσότερο εταιρεία λογισμικού παρά εταιρεία υλικού. Προσέλαβε όλο και περισσότερους μηχανικούς λογισμικού και ερευνητές και έστησε έτσι το ερευνητικό τμήμα της ώστε να αποτελεί την αιχμή του δόρατος της τεχνητής νοημοσύνης.

Στο προηγούμενο συνέδριο GTC 2022 της Nvidia, ο Huang κατέστησε σαφές ότι η εταιρεία επικεντρώνεται στο λογισμικό και τις πλατφόρμες της, αναφέροντας μεταξύ άλλων την AI Enterprise Software Suite, η οποία είχε ξεκινήσει το προηγούμενο έτος. «Το σημαντικό με το λογισμικό μας είναι ότι είναι χτισμένο πάνω στην πλατφόρμα μας», είπε. Αυτό σημαίνει ότι ενεργοποιεί όλα τα τσιπ υλικού και τις πλατφόρμες συστημάτων της Nvidia. Και δευτερευόντως, το λογισμικό που κατασκευάζουμε είναι λογισμικό που καθορίζει τον κλάδο. Τώρα επιτέλους δημιουργήσαμε ένα προϊόν που μπορεί να αδειοδοτηθεί από μια επιχείρηση. Το ζητούσαν, δεν μπορούν απλά να πάνε στον ανοιχτό κώδικα, να κατεβάσουν όλα τα πράγματα και να τα κάνουν να λειτουργήσουν για την επιχείρησή τους. Δεν μπορούσαν παρά να πάνε στο Linux, να κατεβάσουν λογισμικό ανοιχτού κώδικα και να λειτουργήσουν μια εταιρεία πολλών δισεκατομμυρίων δολαρίων με αυτό».α και να διοικήσουν μια εταιρεία πολλών δισεκατομμυρίων δολαρίων με αυτό”.

Συνέπεια της προσέγγισης της πλατφόρμας είναι ότι κάθε φορά που ένας πελάτης αγοράζει από την Nvidia, δεν αγοράζει απλώς το λογισμικό, αλλά αγοράζει την αλυσίδα αξίας της Nvidia. Αυτός ήταν άλλος ένας βασικός πυλώνας της στρατηγικής της Nvidia. Με την GPU και το CUDA, καθώς και με τη στρατηγική καναλιών της Nvidia, η οποία περιέβαλε τους πελάτες με επιλογές και προμήθειες που οι πελάτες γνωρίζουν καλύτερα, δημιούργησε έναν σφόνδυλο ανάπτυξης του οικοσυστήματος.

Οι αντίθετοι άνεμοι της Nvidia

Στα τέλη της δεκαετίας του 2010, οι νεοσύστατες επιχειρήσεις τσιπ τεχνητής νοημοσύνης άρχισαν να κάνουν θραύση, από την Graphcore και την Cerebras μέχρι την SambaNova. Eκείνη την εποχή, η επικρατούσα σοφία ήταν ότι εφόσον οι νεοσύστατες επιχειρήσεις σχεδίαζαν τσιπ ειδικά για την τεχνητή νοημοσύνη, θα ήταν καλύτερα από αυτά της Nvidia. Αυτό δεν έγινε όμως. H Nvidia μπόρεσε να καινοτομήσει τόσο στο υλικό όσο και στο λογισμικό της για να διατηρήσει το προβάδισμά της. Τούτου λεχθέντος, το προβάδισμά τους έχει μειωθεί. Η Habana Labs, που ανήκει στην Intel, είχε πολύ καλά αποτελέσματα στο τσιπ Habana Gaudi2 ενώ το TPU4 της Google φαίνεται πολύ καλό και είναι ανταγωνιστικό με το A100.

Αλλά η Nvidia έχει στα φτερά της το H100, που όλοι περιμένουν με αγωνία να βγει σε μεγάλους όγκους παραγωγής. Το νέο τσιπ Hopper H100 χρησιμοποιεί μια νέα αρχιτεκτονική που έχει σχεδιαστεί για να αποτελέσει τον «κινητήρα» για υποδομές Τεχνητής Νοημοσύνης με μαζική κλιμάκωση. Περιλαμβάνει ένα νέο συστατικό που ονομάζεται Μηχανή Μετασχηματιστή και είναι ειδικά βελτιστοποιημένο για την εκπαίδευση και την εξαγωγή συμπερασμάτων του στρώματος μετασχηματιστή, το οποίο αποτελεί το δομικό στοιχείο του GPT (το ChatGPT, για παράδειγμα, είναι ένας παραγωγικός προ-εκπαιδευμένος μετασχηματιστής).

Επιπλέον, ακόμη και αν αμφισβητηθεί η τρέχουσα ανταγωνιστικότητα του CUDA, η Nvidia το αντικαθιστά επίσης με το τελευταίο λογισμικό υψηλότερου επιπέδου, το οποίο εξειδικεύεται σε συγκεκριμένες περιπτώσεις χρήσης - όπως η τεχνητή νοημοσύνη για την υγειονομική περίθαλψη και η τεχνητή νοημοσύνη για ψηφιακά δίδυμα/ολοκληρωμένο σύμπαν.

Τέλος, ακόμη και αν όλες οι ανταγωνιστικές τάσεις άρχιζαν να υλοποιούνται το δεύτερο εξάμηνο του τρέχοντος έτους, δεν θα είχαν ουσιαστικό αντίκτυπο στα έσοδα της Nvidia μέχρι το 2024. Ακόμη και τότε, όλοι οι ανταγωνιστές μαζί θα μπορούσαν να αποκτήσουν μόλις το 10% της αγοράς.

Παρόλα αυτά, άλλοι αναλυτές λένε ότι η Nvidia δεν έχει πλέον τους καθαρούς όρους ανταγωνισμού που είχε κάποτε, οι οποίοι της επέτρεπαν να κυριαρχεί στην αγορά. Επίσης, με ορισμένους Κινέζους προμηθευτές να μην έχουν πρόσβαση στις GPU της Nvidia, θα προσπαθήσουν να επιταχύνουν την ανταγωνιστική τεχνολογία.

Σε κάθε περίπτωση, η Nvidia φαίνεται να πιστεύει ότι είναι δύσκολο για τους ανταγωνιστές της να εισέλθουν στην αγορά της τεχνητής νοημοσύνης και να δημιουργήσουν μια λύση που να λειτουργεί, να μην είναι πολύ περίπλοκη και να χρησιμοποιεί το λογισμικό που θέλουν οι προγραμματιστές.

Η ευκαιρία της Nvidia με την παραγωγική Τεχνητή Νοημοσύνη

Ο Catanzaro έφυγε από την Nvidia το 2014 για να εργαστεί στην Baidu μαζί με τον Andrew Ng, αλλά επέστρεψε στην Nvidia το 2016 για να ηγηθεί ενός νέου εργαστηρίου που επικεντρώνεται στην εφαρμοσμένη έρευνα βαθιάς μάθησης. Εκείνη την εποχή, ήταν το μοναδικό μέλος. Επτά χρόνια αργότερα, ηγείται μιας ομάδας 40 ερευνητών. Η επιχείρηση επιταχυνόμενων υπολογιστών της Nvidia, είπε, απαιτεί από την ομάδα του να αντιλαμβάνεται κάθε εφαρμογή ως ένα βελτιστοποιημένο σύνολο.

"Δεν αναθέτουμε καμία από αυτές τις ευθύνες σε τρίτους", είπε. Η Nvidia, εξήγησε, αντιμετωπίζει τα προβλήματα ολόκληρα από την κορυφή προς τα κάτω, από τα τσιπ μέχρι τις εφαρμογές, τους αλγορίθμους, τις βιβλιοθήκες, το πλαίσιο μεταγλωττιστών και τη διασυνδεδεμένη αρχιτεκτονική κέντρων δεδομένων. Οι ερευνητές της έχουν την ελευθερία να προωθήσουν την επιτάχυνση "πολύ πέρα από αυτό που θα μπορούσαμε να κάνουμε αν περιοριζόμασταν να σκεφτούμε μόνο ένα μέρος αυτής της στοίβας".

Και με τη νέα εποχή του ChatGPT, η Nvidia μπορεί να προχωρήσει ακόμη περισσότερο, πρόσθεσε. "Οι εταιρείες θα πιέσουν πραγματικά για την εφαρμογή της τεχνητής νοημοσύνης σε πολλά διαφορετικά προβλήματα", είπε. "Αυτό, φυσικά, κάνει τη δουλειά μου ακόμη πιο συναρπαστική.

Ο Huang, επίσης, έχει αναφερθεί στη μετασχηματιστική στιγμή του ChatGPT. "Αυτή είναι η στιγμή του iPhone για την τεχνητή νοημοσύνη", δήλωσε στο Haas School of Business του Μπέρκλεϊ.

Από το AlexNet το 2012, το ταξίδι της Nvidia στην Τεχνητή Νοημοσύνη είχε πάντα ως στόχο την αξιοποίηση των ευκαιριών που ανοίγονταν - ακόμη και αν, στην περίπτωση των GPU, ήταν απροσδόκητο. Έτσι, η Nvidia βρίσκεται αναμφίβολα σε ένα καλό σημείο. Ακριβώς όπως η GPU της εταιρείας βρισκόταν στο κέντρο της τροφοδοσίας της επανάστασης της βαθιάς μάθησης πριν από μια δεκαετία, το υλικό και το λογισμικό της Nvidia βρίσκονται πίσω από τα παρασκήνια της σημερινής τεχνολογίας παραγωγικής Τεχνητής Νοημοσύνης που “διψά” για GPU. Και φαίνεται ότι δεν έχει σημασία ποιες εταιρείες βγαίνουν στην κορυφή (Google, Microsoft OpenAI κλπ,) μια και είναι η Nvidia που τα προμηθεύει όλα και θα κερδίσει σίγουρα πολλά.

Πηγή άρθρου: VentureBeat